- Главная

- Разное

- Образование

- Спорт

- Естествознание

- Природоведение

- Религиоведение

- Французский язык

- Черчение

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, фоны, картинки для презентаций

- Экология

- Экономика

Презентация, доклад по информатике на тему Суперкомпьютеры

Содержание

- 1. Презентация по информатике на тему Суперкомпьютеры

- 2. СодержаниеОпределение суперкомпьютераТип архитектур(1) (2) История сравненийРейтинг 10-ка

- 3. Определение СуперкомпьютераСуперкомпьютер — специализированная вычислительная машина, значительно

- 4. Типы архитектур Основной параметр классификации параллельных компьютеров

- 5. Типы архитектурУ параллельных компьютеров с общей памятью

- 6. История сравненийВ начале 1990-х годов возникла необходимость

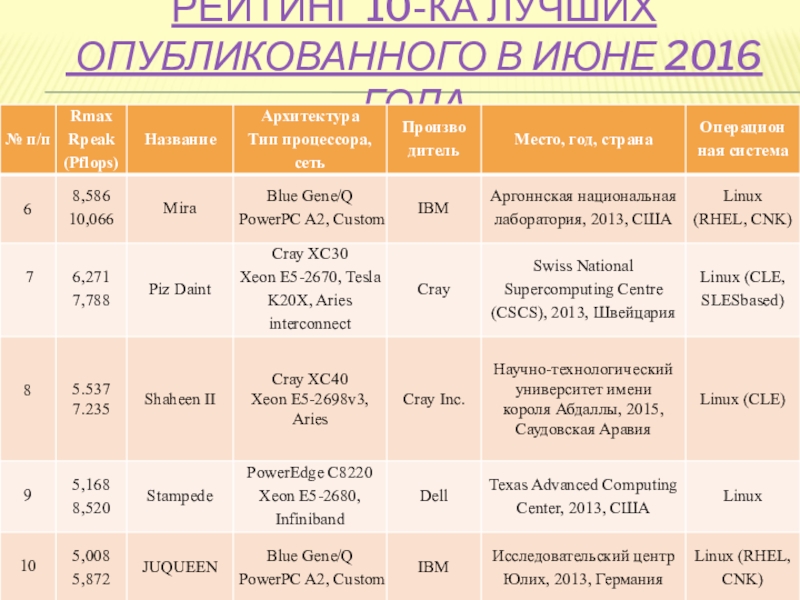

- 7. Рейтинг 10-ка лучших опубликованного в июне 2016 года

- 8. Рейтинг 10-ка лучших опубликованного в июне 2016 года

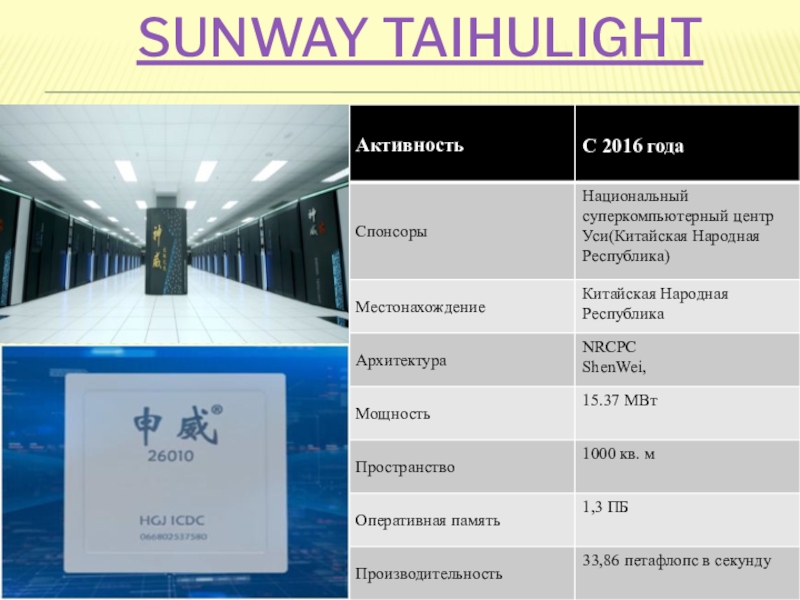

- 9. Sunway TaihuLight

- 10. АрхитектураДанный суперкомпьютер использует более чем 10,5 миллиона

- 11. ПрименениеСуперкомпьютер Sunway TaihuLight предназначен для сложных расчётов,

- 12. Tianhe-2

- 13. Tianhe-2 ОписаниеТяньхэ-2 состоит из 16 тысяч узлов,

- 14. Titan

- 15. Titan

- 16. Titan Архитектура и устройствоTitan – суперкомпьютер компании

- 17. Titan ПрименениеОсновная доля компьютерного времени Titan-а будет

- 18. IBM Sequoia

- 19. IBM SequoiaSequoia – проект суперкомпьютера петафлопсной производительности,

- 20. IBM Sequoia Цели и архитиктураSequoia будет использоваться

- 21. K computer

- 22. K computer

- 23. K computerK computer – японский суперкомпьютер производства

- 24. Mira

- 25. Mira

- 26. MiraКонфигурация интерконнекта 5D от IBM со скоростью

- 27. Piz Daint

- 28. Piz Daint

- 29. Piz DaintМощнейшая в Европе вычислительная система Piz

- 30. Shaheen II

- 31. Shaheen II

- 32. Shaheen IIРасположение: Научно-технологический университет имени короля Абдаллы

- 33. Stampede

- 34. StampedeТехасский компьютерный центр (TACC) создал суперкомпьютер, способный

- 35. Описание и применениеСуперкомпьютер Stampede создан компанией Dell

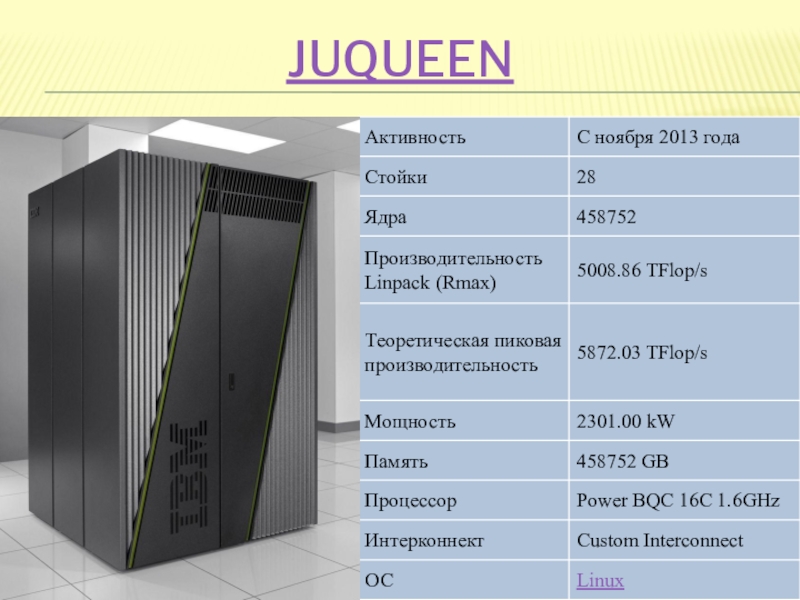

- 36. JUQUEEN

- 37. JUQUEENСуперкомпьютер JUQUEEN занимает 24 стойки и состоит

- 38. Финансирование JUQUEENJUQUEEN в равных долях финансируется федеральным

- 39. Рейтиг российских суперкомпьютеровЧто касается российских суперкомпьютеров, то

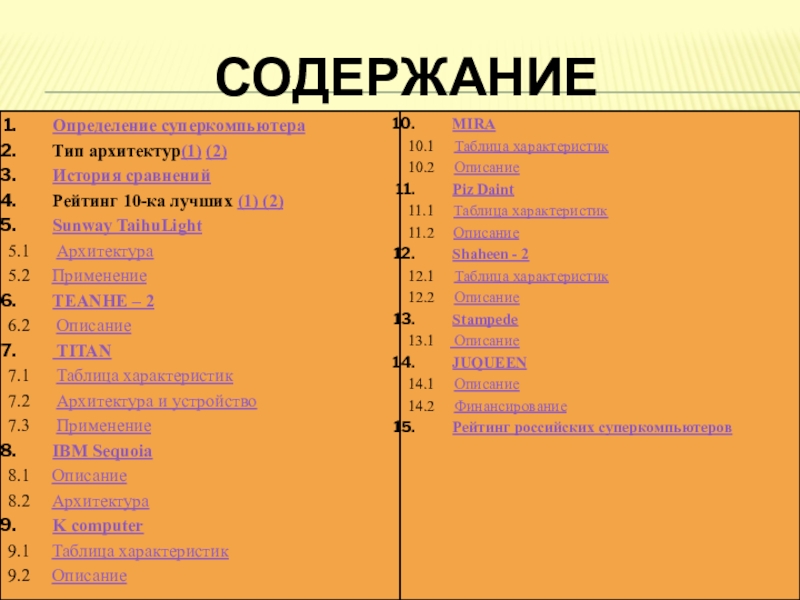

Слайд 2Содержание

Определение суперкомпьютера

Тип архитектур(1) (2)

История сравнений

Рейтинг 10-ка лучших (1) (2)

Sunway TaihuLight

5.1 Архитектура

5.2 Применение

TEANHE – 2

6.2 Описание

TITAN

7.1 Таблица характеристик

7.2 Архитектура и устройство

7.3 Применение

IBM Sequoia

8.1 Описание

8.2 Архитектура

K computer

9.1 Таблица характеристик

9.2 Описание

MIRA

10.1 Таблица характеристик

10.2 Описание

Piz Daint

11.1 Таблица характеристик

11.2 Описание

Shaheen - 2

12.1 Таблица характеристик

12.2 Описание

Stampede

13.1 Описание

JUQUEEN

14.1 Описание

14.2 Финансирование

Рейтинг российских суперкомпьютеров

Слайд 3Определение Суперкомпьютера

Суперкомпьютер — специализированная вычислительная машина, значительно превосходящая по своим техническим

Суперкомпьютер – это компьютер, способный производить сотни миллиардов операций за 1 с. Такие большие объёмы вычислений нужны для решения задач в аэродинамике, метеорологии, физике высоких энергий, геофизике. Суперкомпьютеры так же нашли своё применение в финансовой сфере при обработке больших объёмов сделок на биржах. Сверхвысокое быстродействие суперкомпьютера обеспечивается параллельной работой множества микропроцессоров.

Слайд 4Типы архитектур

Основной параметр классификации параллельных компьютеров - наличие общей или распределенной

Идея массивно-параллельных систем с распределенной памятью (Massively Parallel Processing, MPP) довольно проста. Для этой цели берутся обычные микропроцессоры, каждый из которых снабжают своей локальной памятью и соединяют посредством некоей коммутационной среды. Достоинств у такой архитектуры много. Если нужна высокая производительность, то можно добавить еще процессоров, а если ограничены финансы или заранее известна требуемая вычислительная мощность, то легко подобрать оптимальную конфигурацию. Однако у MPP есть и недостатки. Дело в том, что взаимодействие между процессорами идет намного медленнее, чем обработка данных самими процессорами.

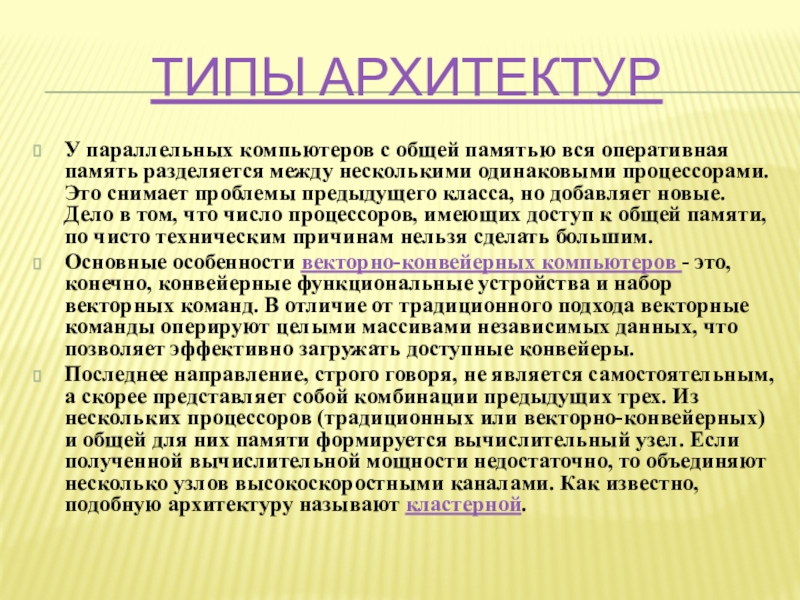

Слайд 5Типы архитектур

У параллельных компьютеров с общей памятью вся оперативная память разделяется

Основные особенности векторно-конвейерных компьютеров - это, конечно, конвейерные функциональные устройства и набор векторных команд. В отличие от традиционного подхода векторные команды оперируют целыми массивами независимых данных, что позволяет эффективно загружать доступные конвейеры.

Последнее направление, строго говоря, не является самостоятельным, а скорее представляет собой комбинации предыдущих трех. Из нескольких процессоров (традиционных или векторно-конвейерных) и общей для них памяти формируется вычислительный узел. Если полученной вычислительной мощности недостаточно, то объединяют несколько узлов высокоскоростными каналами. Как известно, подобную архитектуру называют кластерной.

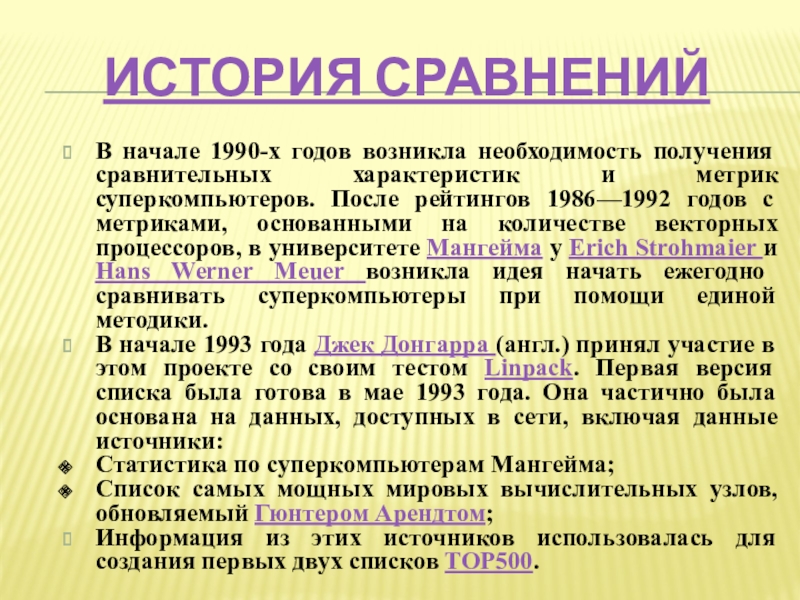

Слайд 6История сравнений

В начале 1990-х годов возникла необходимость получения сравнительных характеристик и

В начале 1993 года Джек Донгарра (англ.) принял участие в этом проекте со своим тестом Linpack. Первая версия списка была готова в мае 1993 года. Она частично была основана на данных, доступных в сети, включая данные источники:

Статистика по суперкомпьютерам Мангейма;

Список самых мощных мировых вычислительных узлов, обновляемый Гюнтером Арендтом;

Информация из этих источников использовалась для создания первых двух списков TOP500.

Слайд 10Архитектура

Данный суперкомпьютер использует более чем 10,5 миллиона процессорных ядер и работает

В суперкомпьютере используются многоядерные 64-битные RISC-процессоры SW26010, базирующиеся на архитектуре ShenWei. Общее количество процессоров в системе — 40 960, каждый процессор содержит 256 вычислительных ядер общего назначения и 4 управляющих ядра, что в совокупности даёт 10 649 600 ядер.

Процессорные ядра содержат 64 КБ внутренней памяти для данных и ещё 16 КБ для инструкций и сообщаются с помощью сети на чипе вместо использования традиционной иерархии кэш-памяти.

В Sunway TaihuLight используются процессоры китайского производства.

Слайд 11Применение

Суперкомпьютер Sunway TaihuLight предназначен для сложных расчётов, требуемых в производстве, медицине,

Слайд 13Tianhe-2

Описание

Тяньхэ-2 состоит из 16 тысяч узлов, каждый из которых включает 2

Используется ОС Kylin Linux. Доступные языки и технологии: Fortran, C++, Java, OpenMP, MPI 3.0 (MPICH2 3.0.4, каналы GLEX).

Система хранения данных имеет объём 12,4 ПБ и использует гибридную файловую систему H2FS.

По оценкам, создание суперкомпьютера обошлось в сумму порядка 200-300 миллионов долларов.

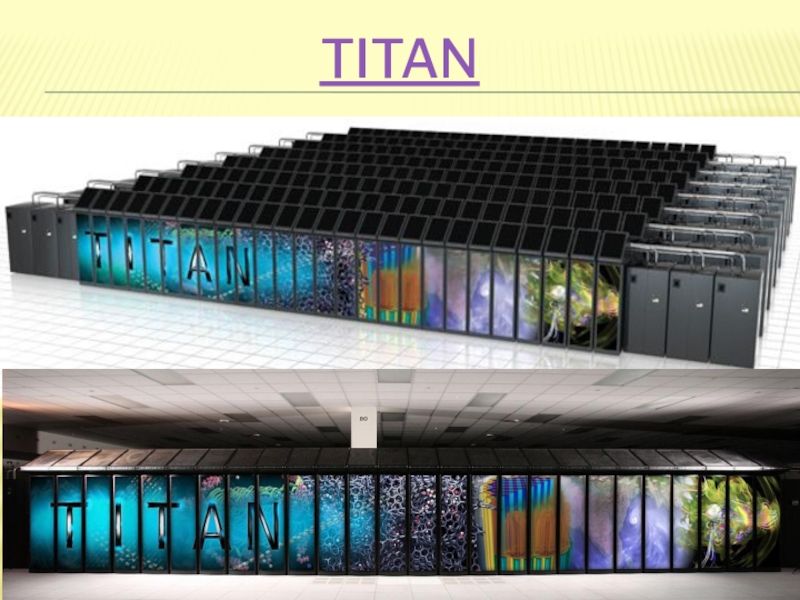

Слайд 16Titan

Архитектура и устройство

Titan – суперкомпьютер компании Cray Inc. установленный в национальной

Построенный на платформе Cray XK7 с гибридной архитектурой: помимо 16-ядерных процессоров AMD Opteron 6274 в каждый из 18 688 узлов суперкомпьютерной системы установлен графический процессор общего назначения NVIDIA Tesla K20x (архитектура Kepler). Таким образом общее число ядер компьютера составляет 299 008. Компилятор, специально разработанный для Titan-а, автоматически распараллеливает исполнение кода между центральным и графическим процессорами.

Слайд 17Titan

Применение

Основная доля компьютерного времени Titan-а будет отдана под приложения государственной программы

Первыми проектами, которые получат доступ к Titan-у являются:

Процессы сгорания топлива: С помощью приложения S3D исследователи могут смоделировать турбулентное сгорание различных видов и составов топлива.

Наука о материалах: С помощью приложения WL-LSMS исследователи смогут находить и создавать новые материалы, исследуя их магнитные свойства при разных температурах на нано-уровне.

Атомная энергия: С помощью приложения Denovo исследователи смогут моделировать поведение нейтронов в ядерном реакторе.

Изменения климата: Программа Community Atmosphere Model-Spectral Element (CAM-SE) симулирует долгосрочные глобальные изменения климата.

Слайд 19IBM Sequoia

Sequoia – проект суперкомпьютера петафлопсной производительности, основанный на архитектуре Blue

14 июня 2012 года в рамках проекта TOP500 было объявлено, что суперкомпьютер Sequoia стал самым производительным в мире и сместил с первого места японский K computer. Производительность в тесте LINPACK составила 16,32 петафлопс на 1 572 864 ядрах.

Слайд 20IBM Sequoia

Цели и архитиктура

Sequoia будет использоваться в основном для моделирования ядерных

Sequoia построена по архитектуре Blue Gene/Q, являющейся последним поколением в линейке суперкомпьютерных архитектур Blue Gene. Суперкомпьютер состоит из 98 304 вычислительных узлов и имеет 1,6 Пб памяти в 96 стойках, расположенных на площади в 300 кв. м. Используются 16-ти или 8-ми ядерные центральные процессоры POWER, изготовленные по техпроцессу 45 нм.

При высокой энергоэффективности в расчёте на флопс производительности (3000 Мфлопс/ватт – это в 7 раз выше, чем для систем архитектуры Blue Gene/P), энергопотребление комплекса составляет около 6 мегаватт электрической энергии.

Слайд 23K computer

K computer – японский суперкомпьютер производства компании Fujitsu, запущенный в

По состоянию на июнь 2011 года система имела 68.5 8-ядерных процессора SPARC64 VIII fx, что составляло 548.4 вычислительных ядра, произведенных компанией Fujitsu по 45-нанометровому техпроцессу. Суперкомпьютер использует водяное охлаждение, что позволило снизить потребление энергии и увеличить плотность компоновки.

В ноябре 2011 года K Computer был достроен, количество процессоров достигло 88.2, таким образом, K Computer стал первым в истории суперкомпьютером, преодолевшим рубеж в 10 Пфлопс. Пиковое быстродействие комплекса достигает 11,3 квадриллиона операций с плавающей запятой в секунду.

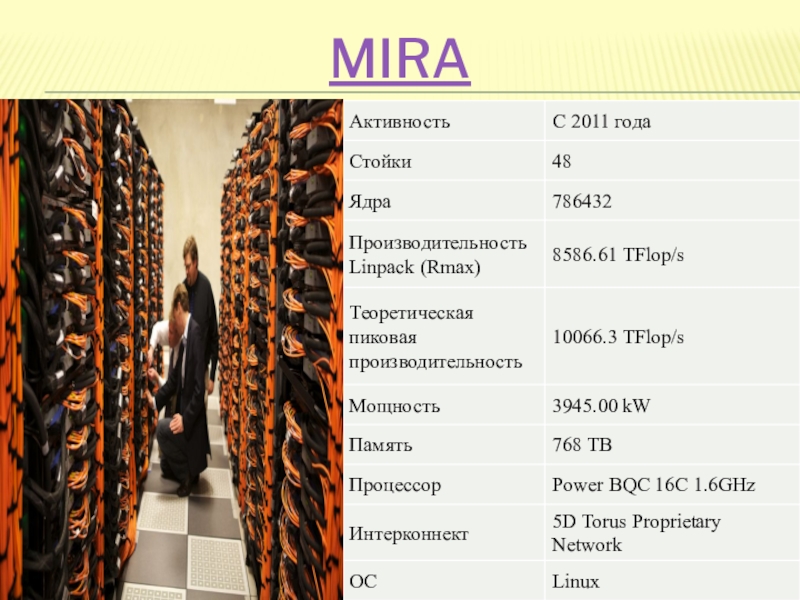

Слайд 26Mira

Конфигурация интерконнекта 5D от IBM со скоростью chip-to-chip соединения в 2

Mira предоставляет доступ к файловой системе GPFS емкостью 24 ПБ и пропускной способностью 240 Гб/с. Пользователи также получат доступ к HPSS архивам данных и Tukey, новому кластеру анализа и визуализации. Все ресурсы доступны через быстродействующие сети, включая ESnet, недавно модернизированную до 100 Гб/с.

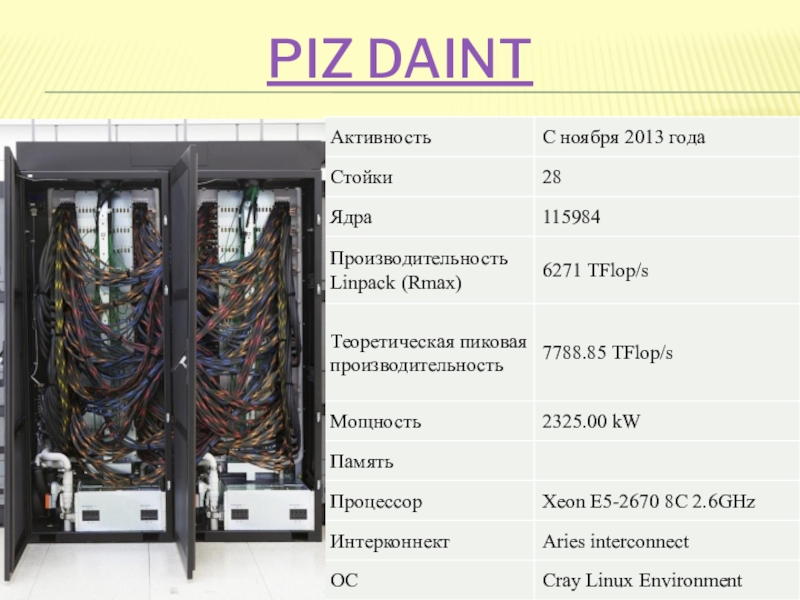

Слайд 29Piz Daint

Мощнейшая в Европе вычислительная система Piz Daint была запущена компаний

Суперкомпьютер использует 5.272 видеокарт Tesla K20X и состоит из 28 стоек. Система может развивать вычислительную производительность до 6,27 петафлопов (Rmax). Возможна краткосрочная пиковая нагрузка до 7,8 петафлопов (Rpeak).

Слайд 32Shaheen II

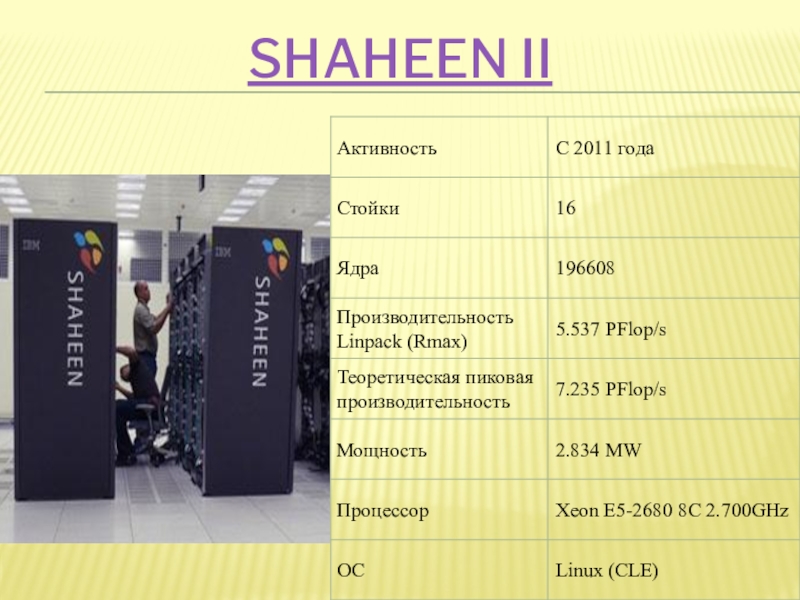

Расположение: Научно-технологический университет имени короля Абдаллы (King Abdullah University of

Shaheen II построен на платформе CRAY XC40. В системе используются 16-ядерные процессоры Intel Xeon E5-2698V3.

Суперкомпьютер применяется для решения сложных вычислительных задач в нуждах нефтегазовой, энергетической, геологоразведывательной и других отраслей. Также среди перспективных направлений для работы указывается биоинжиниринг.

Слайд 34Stampede

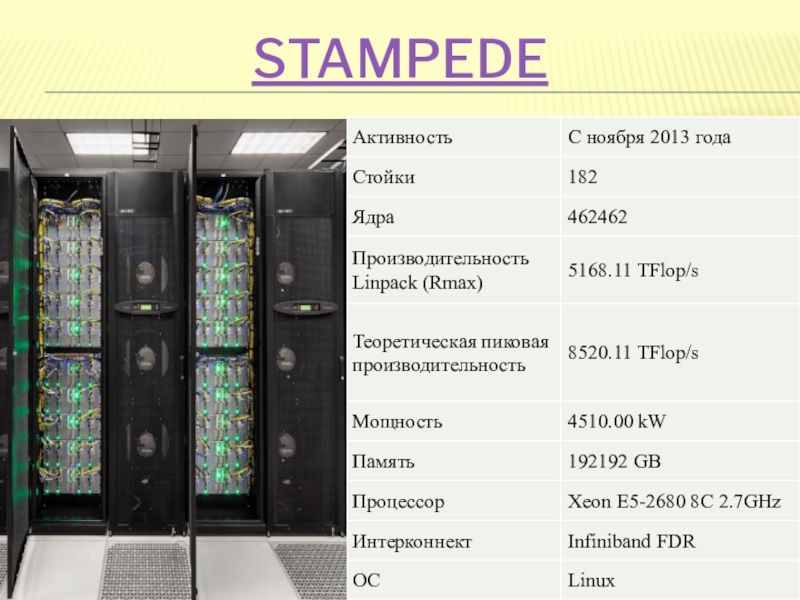

Техасский компьютерный центр (TACC) создал суперкомпьютер, способный выполнять 2,7 квадриллионов операций

В основе Stampede лежит архитектура Dell, использующая 8-ядерные процессоры Intel Xeon E5-2680. А с 2013 года Stampede начал использовать новые сопроцессоры Intel Xeon Phi, предназначенные для выполнения параллельных вычислений, которые ответственны более чем за 7 Пфлопс производительности системы. Помимо Xeon Phi, суперкомпьютер использует 128 графических ускорителей от NVIDIA для обеспечения удаленной виртуализации. Еще одним поставщиком для Stampede является компания Mellanox, предоставляющая сетевое оборудование Infiniband с пропускной способностью 56 Гбит/с.

Система охлаждения суперкомпьютера построена по принципу изоляции горячих зон и предполагает использование встраиваемых модулей охлаждения, что позволяет размещать оборудование с высокой плотностью до 40 кВт на стойку. Система распределения питания подает напряжение 415 В на стойки и 240 В на сервера. Потребности в электроэнергии систем Stampede и Ranger обеспечиваются электроподстанцией мощностью в 10 МВт.

Слайд 35Описание и применение

Суперкомпьютер Stampede создан компанией Dell совместно с Intel для

Stampede используется для таких задач, как моделирование изменений климата, предсказание землетрясений и ураганов, изучение ДНК вирусов, молекулярные исследования, космические исследования.

Слайд 37JUQUEEN

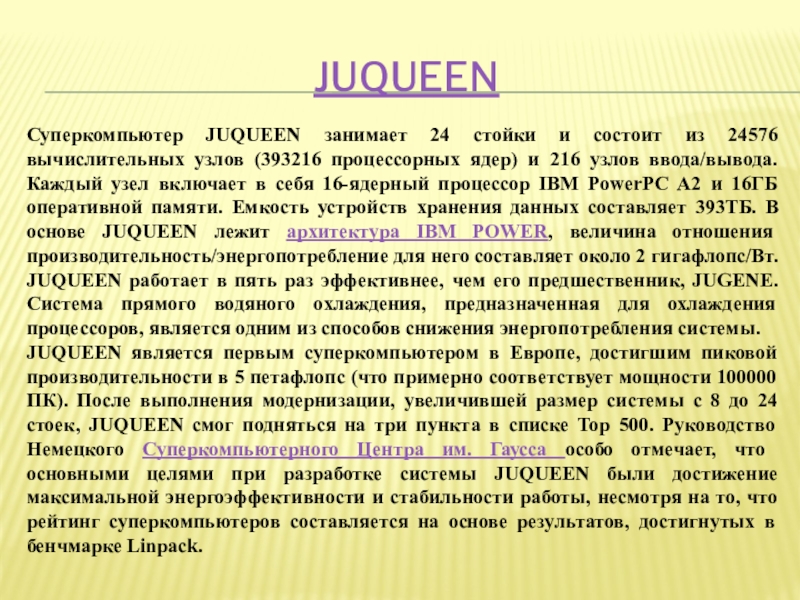

Суперкомпьютер JUQUEEN занимает 24 стойки и состоит из 24576 вычислительных узлов

JUQUEEN является первым суперкомпьютером в Европе, достигшим пиковой производительности в 5 петафлопс (что примерно соответствует мощности 100000 ПК). После выполнения модернизации, увеличившей размер системы с 8 до 24 стоек, JUQUEEN смог подняться на три пункта в списке Top 500. Руководство Немецкого Суперкомпьютерного Центра им. Гаусса особо отмечает, что основными целями при разработке системы JUQUEEN были достижение максимальной энергоэффективности и стабильности работы, несмотря на то, что рейтинг суперкомпьютеров составляется на основе результатов, достигнутых в бенчмарке Linpack.

Слайд 38Финансирование JUQUEEN

JUQUEEN в равных долях финансируется федеральным и местным правительством, система

Слайд 39Рейтиг российских суперкомпьютеров

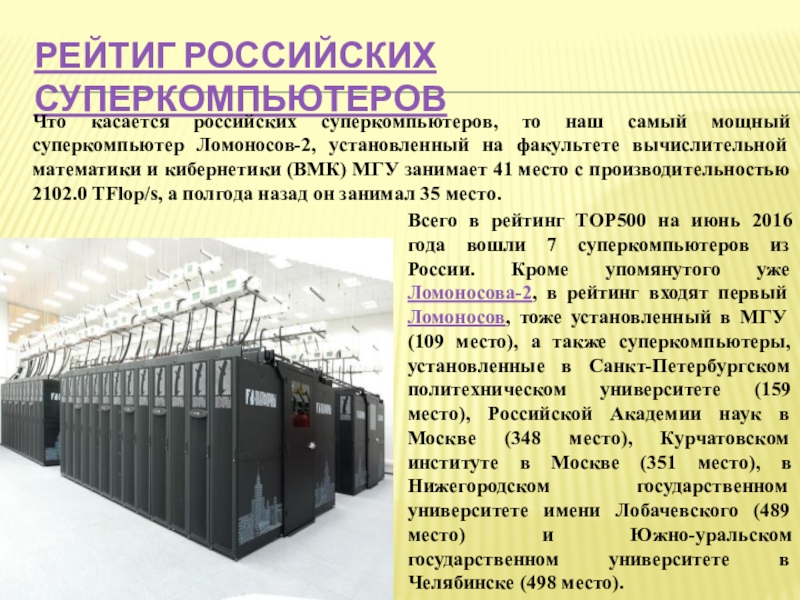

Что касается российских суперкомпьютеров, то наш самый мощный суперкомпьютер

Всего в рейтинг TOP500 на июнь 2016 года вошли 7 суперкомпьютеров из России. Кроме упомянутого уже Ломоносова-2, в рейтинг входят первый Ломоносов, тоже установленный в МГУ (109 место), а также суперкомпьютеры, установленные в Санкт-Петербургском политехническом университете (159 место), Российской Академии наук в Москве (348 место), Курчатовском институте в Москве (351 место), в Нижегородском государственном университете имени Лобачевского (489 место) и Южно-уральском государственном университете в Челябинске (498 место).